hadoop的常用命令,hadoop 常用命令

作者:admin 发布时间:2024-11-12 02:17 分类:资讯 浏览:1

本篇文章给大家谈谈hadoop的常用命令,以及hadoop 常用命令对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、hadoop中常用的命令

- 2、搭建hadoop集群,常用配置文件是什么,以及配置哪些属性

- 3、hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

- 4、HDFS操作命令

- 5、Hive的几种常见的数据导入方式

hadoop中常用的命令

1、Hadoop的命令有:ctrl+r:搜索历史命令、ctrl+q:退出、cd...:返回上一级目录、.mkdir:创建文件夹。

2、启动hadoop的命令是:`start-dfs.sh` 和 `start-yarn.sh`。这两个命令分别用于启动Hadoop分布式文件系统(HDFS)和Hadoop资源管理器(YARN)。要启动Hadoop,请按照以下步骤操作:打开终端或命令提示符窗口。

3、chmod用于改变文件或目录的访问权限,这个Linux系统管理员最常用的命令之一。 使用方法:hadoop fs -chmod [-R] ... 使用-R将使改变在目录结构下递归进行。

搭建hadoop集群,常用配置文件是什么,以及配置哪些属性

1、准备基础环境:- 安装并配置JDK。- 配置/etc/hosts文件,确保节点间能通过主机名相互访问。- 配置SSH无密码登录,以便在节点间执行命令。- 创建必要的文件目录,为Hadoop准备存储空间。

2、hadoop的配置文件均以XML文件进行配置,它有四个最常见的配置文件,分别为:core-site.xml文件主要用于配置通用属性。hdfs-site.xml文件用于配置Hdfs的属性。mapred-site.xml文件用于配置Mapreduce的属性。

3、通过hadoop.user.name属性配置。 HDFS Haocho模式的辅助NameNode地址 通过ha.namenodes属性配置。

4、搭建Hadoop大数据平台的主要步骤包括:环境准备、Hadoop安装与配置、集群设置、测试与验证。环境准备 在搭建Hadoop大数据平台之前,首先需要准备相应的硬件和软件环境。

5、是的,Hadoop搭建过程中设置元数据文件存储路径的配置文件是hdfs-site.xml。在Hadoop集群中,元数据指的是HDFS(Hadoop Distributed File System)存储的文件系统命名空间和其他相关信息,例如文件副本的位置和块的位置等。

6、我们用HADOOP_HOME指代安装的根路径。通常,集群里的所有机器的HADOOP_HOME路径相同。配置 接下来的几节描述了如何配置Hadoop集群。

hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

常见的在伪分布式环境下使用的Shell命令包括:start-dfs.sh启动分布式文件系统、start-yarn.sh启动资源管理器、hadoop fs操作分布式文件系统、hadoop jar运行Hadoop任务等。

启动Hadoop 启动Hadoop集群需要启动HDFS集群和Map/Reduce集群。

纯属键盤上乱打所致的。都是在左手部位的字母。

从fs -ls从列出来的文件看,这个文件夹/user/root/input是通过root用户创建的。

调用文件系统(FS)Shell命令应使用 bin/hadoop fs args的形式。 所有的的FS shell命令使用URI路径作为参数。URI格式是scheme://authority/path。对HDFS文件系统,scheme是hdfs,对本地文件系统,scheme是file。

HDFS操作命令

chgrp命令可用于更改HDFS中文件或目录的所有者组。例如,要将文件foo.txt的所有者组更改为“hadoop”,您可以使用以下命令:hdfsdfs-chgrphadoop/path/to/foo.txt这将更改foo.txt文件的所有者组为“hadoop”。

方法如下:添加本地文件到hdfs目录:hadoopfs-put的命令后面的第一个参数是本地路径,第二个参数是hadoopHDFS上的路径,意思就是将本地路径加载到HDFS上。创建文件夹:在hadoop的HDFS上创建文件夹。

重命名文件:将文件名从0或1开头更改为其他字符。

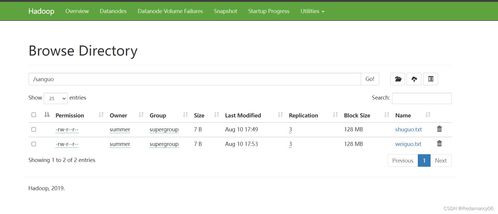

在浏览器中查看hdfs运行状态,网址:http://node1:50070 ()停止Hadoop。

启动Hadoop 启动Hadoop集群需要启动HDFS集群和Map/Reduce集群。

Hive的几种常见的数据导入方式

今天我们再谈谈Hive中的三种不同的数据导出方式。根据导出的地方不一样,将这些方式分为三种:(1)、导出到本地文件系统;(2)、导出到HDFS中;(3)、导出到Hive的另一个表中。

讲MR输出数据到hive表的location分区目录,然后通过Sql添加分区即可。ALTERTABLEtable_nameADDPARTITION(partCol=value1)locationlocation_path换成自己的表,分区字段和path。

如何把sql server中的数据导入hive,再导入hbase-CSDN论坛 方法有两种: 一种是通过Java,直接读取数据,然后在插入hive中 第二种是整合hbase,hive。

利用选项2,先打通Hive对HBase指定表的全表访问,再建立一个新的空表,把查询出来的数据全部导入到新表当中,以后的所有数据分析操作在新表中完成。说干就干,让我们试一个简单的例子。

mysql同步数据到hive大部分公司目前都是走的jdbc的方式。这种方式有两个好处:也有不好的地方:这一步最主要的细节是将mysql库的所有binlog数据全部打入一个kafka topic,格式使用json。

如果hdfs中是格式化数据的话,可以使用sqoop命令工具来将数据导入到mysql 具体使用方式,你可以网上查找一下,资料蛮丰富的。

hadoop的常用命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于hadoop 常用命令、hadoop的常用命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接