hadoop的基本命令,hadoop的基础

作者:admin 发布时间:2024-11-11 13:00 分类:资讯 浏览:1

今天给各位分享hadoop的基本命令的知识,其中也会对hadoop的基础进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

- 1、hadoop常用shell命令怎么用

- 2、hadoop返回上一级目录命令

- 3、学习hadoop需要理解启动脚本吗

- 4、HDFS操作命令

- 5、大数据:Hadoop入门

- 6、hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

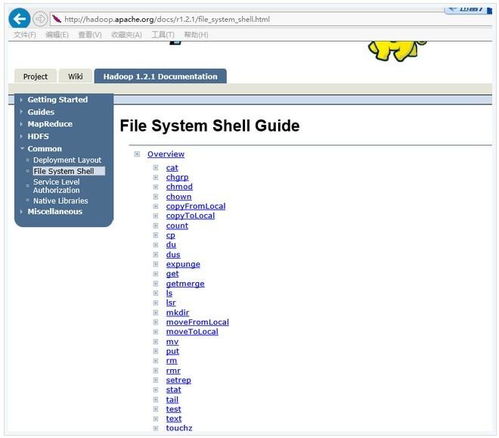

hadoop常用shell命令怎么用

1、使用方法:hadoop fs -copyFromLocal localsrc URI除了限定源路径是一个本地文件外,和put命令相似。copyToLocal使用方法:hadoop fs -copyToLocal [-ignorecrc] [-crc] URI localdst除了限定目标路径是一个本地文件外,和get命令类似。

2、bin=`cd$bin; pwd`,切换到start-all.sh的所在目录下,并将路径赋值给bin。DEFAULT_LIBEXEC_DIR=$bin/../libexec,获取${HADOOP_HOME}/libexec的绝对路径以备后用。

3、hadoop查看每个目录的路径需要验证数据。点击shell命令,hadoopfscountq目录ps,查看目录下总的大小。dfscount目录ps,一样的,hadoopfsdu目录ps,查看目录下每个子目录的路径。

4、安装Hadoop ()获取Hadoop压缩包hadoop-0.tar.gz,下载后可以使用VMWare Tools通过共享文件夹,或者使用Xftp工具传到node1。

hadoop返回上一级目录命令

按下F10(或者Fn+F10)。输入用户名。cd$HADOOP_HOME//进入Hadoop安装目录。

hadoop fs -cp /user/hadoop/file1 /user/hadoop/file2 /user/hadoop/dir 返回值:成功返回0,失败返回-1。du使用方法:hadoop fs -du URI [URI …]显示目录中所有文件的大小,或者当只指定一个文件时,显示此文件的大小。

hadoop查看每个目录的路径需要验证数据。点击shell命令,hadoopfscountq目录ps,查看目录下总的大小。dfscount目录ps,一样的,hadoopfsdu目录ps,查看目录下每个子目录的路径。

学习hadoop需要理解启动脚本吗

1、要启动Hadoop的各节点和其他服务,这是一个绕不开的启动脚本,该脚本位于${HADOOP_HOME}/sbin下。不过在Hadoop的x版本中,Hadoop官方已经宣布被弃用了。

2、⑤ 需要具备一定的javase基础知识;⑥ 如果懂java web及各种框架知识那就更好了。虚拟机:⑦ 需要掌握虚拟机;⑧ 需要安装linux操作系统。⑨ 需要配置虚拟机网络。

3、要启动Hadoop,请按照以下步骤操作:打开终端或命令提示符窗口。导航到Hadoop的安装目录。

4、了解Hadoop运行机制,可以学习Hadoop权威指南或者Hadoop实战;了解Hadoop运行流程,看懂HADOOP_HOME/bin/下面主要执行脚本。

HDFS操作命令

1、chgrp命令可用于更改HDFS中文件或目录的所有者组。例如,要将文件foo.txt的所有者组更改为“hadoop”,您可以使用以下命令:hdfsdfs-chgrphadoop/path/to/foo.txt这将更改foo.txt文件的所有者组为“hadoop”。

2、方法如下:添加本地文件到hdfs目录:hadoopfs-put的命令后面的第一个参数是本地路径,第二个参数是hadoopHDFS上的路径,意思就是将本地路径加载到HDFS上。创建文件夹:在hadoop的HDFS上创建文件夹。

3、在浏览器中查看hdfs运行状态,网址:http://node1:50070 ()停止Hadoop。

4、从fs -ls从列出来的文件看,这个文件夹/user/root/input是通过root用户创建的。

5、方法1:使用hive自带sql语法进行删除 alter table 表名 drop partition (etl_dt=20161118);再次查看20161118分区还在不在,如果分区不在了,说明该分区已经被删除,数据也已被清空。

6、创建完成之后,放到hdfs上面 使用hdfs fsck /129M命令 使用hdfs --help 找到对应的fsck命令,解释说fsck是运行一个分布式文件系统的检查工具。

大数据:Hadoop入门

年代末,Google的论文为Hadoop的诞生奠定了理论基础,随后Apache将其开源,开启了大数据处理的新纪元。然而,尽管强大,MapReduce并不适合实时处理或流式计算,其固定结构仅限于单阶段的Map和Reduce,复杂逻辑需顺序执行。

相信大家在学习大数据hadoop的时候肯定会遇到各种各样的问题,这篇文章就是介绍一些常的问题及如何解决的办法。

方法/步骤 第一阶段:大数据前沿知识及hadoop入门,大数据前言知识的介绍,课程的介绍,Linux和unbuntu系统基础,hadoop的单机和伪分布模式的安装配置。第二阶段:hadoop部署进阶。

Apache Hadoop是入门点,或者我们可以说是进入整个大数据生态系统的基础。它是大数据生态系统中大多数高级工具,应用程序和框架的基础,但是在学习Apache Hadoop时,还需要事先知道一些事情。

hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

如果第一批block都读完了,DFSInputStream就会去namenode拿下一批blocks的location,然后继续读,如果所有的block块都读完,这时就会关闭掉所有的流。

命令的使用者必须是文件的所有者或者超级用户。操作hdfs系统可以使用hadoopfs也可以使用hdfsdfs,两者效果一样。(hadoopdfs命令已不再建议使用)。HadoopDistributedFileSystem,简称HDFS,是一个分布式文件系统。

– dfs.replication – 在文件被写入的时候,每一块将要被复制多少份 – 默认是3份。建议3份 – 在客户端上设定 通常也需要在DataNode上设定 HDFS core-site.xml 参数配置 – fs.default.name – 文件系统的名字。

hadoop是什么意思?Hadoop是具体的开源框架,是工具,用来做海量数据的存储和计算的。HDFS为海量的数据提供了存储,而MapReduce则为海量的数据提供了计算。

HDFS中根目录下创建user文件夹的命令为hadoop dfs-mkdir。在hdfs中创建一个input文件夹:hadoop fs -mkdir /input/使用参数-p创建多级目录:hadoop fs -mkdir -p /input/file1。

. hdfs-site.xml配置: 其中dfs.namenode.name.dir和dfs.datanode.data.dir的路径可以自由设置,最好在hadoop.tmp.dir的目录下面。

hadoop的基本命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于hadoop的基础、hadoop的基本命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接