hive常用命令,hive使用教程

作者:admin 发布时间:2024-11-10 04:14 分类:资讯 浏览:2

今天给各位分享hive常用命令的知识,其中也会对hive使用教程进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

程序中的Hive具体是干什么用的呢?

以前大数据分析会用到多种工具,比如数仓工具、数据建模工具、BI工具等等。现在的大数据分析平台,都是全能型数据分析平台,一个平台搞定所有。

本质上只是用来存储hive中有哪些数据库,哪些表,表的模式,目录,分区,索引以及命名空间。为数据库创建的目录一般在hive数据仓库目录下。

数据清洗:MapReduce作为Hadoop的查询引擎,用于大规模数据集的并行计算。数据查询分析:Hive的核心工作就是把SQL语句翻译成MR程序,可以将结构化的数据映射为一张数据库表,并提供HQL(HiveSQL)查询功能。

hive支持频繁数据更新

如何每日增量加载数据到Hive分区表讲MR输出数据到hive表的location分区目录,然后通过Sql添加分区即可。ALTERTABLEtable_nameADDPARTITION(partCol=value1)locationlocation_path换成自己的表,分区字段和path。

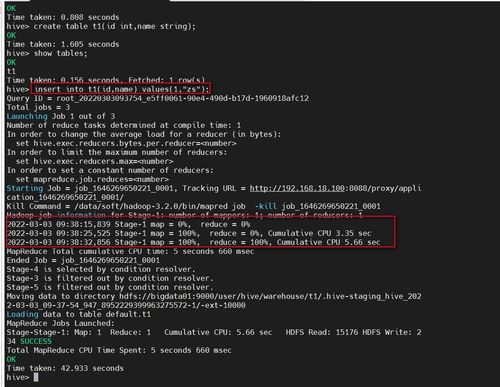

以支持ACID的要求.如以简单的表进行实验:(id int ,name string),随意导入几条数据,进行测试.写入更新操作命令:update set name =aaawhere id =1;得到结果如下:似乎这样操作,HIVE对UPDATE操作就非常好的。

数据更新:Hive不支持数据更新,只可以读,不可以写,而SQL支持数据的读写。索引:Hive没有索引,因此查询数据的时候是通过mapreduce很暴力的把数据都查询一遍,这也是造成Hive查询数据速度很慢的原因,而MySQL有索引。

不是。Hive 的执行延迟比较高,因此 Hive 常用于数据分析,对实时性要求不高的场合。

由于hive数仓的特性,不容许数据进行修改,造成hive中的数据更新活着删除很困难的问题,自hive 0.11版本之后,hive也尝试在测试环境允许进行update和delte操作,但这些操作还不成熟,不敢在生产环境放心使用,其中也有一样不足。

hive的几种连接方式

1、JDBC连接的方式,当然还有其他的连接方式,比如ODBC等, 这种方式很常用,可以在网上随便找到,就不再累赘了。不稳定,经常会被大数据量冲挂,不建议使用。

2、Hive 支持常用的 SQL Join 语句,例如内连接、左外连接、右外连接以及 Hive 独有的 map 端连接。其中 map 端连接是用于优化 Hive 连接查询的一个重要技巧。先准备三张表。

3、由于版本的不同,Python 连接 Hive 的方式也就不一样。在网上搜索关键字 python hive 的时候可以找到一些解决方案。

4、因此,就产生的JDBC连接的方式,当然还有其他的连接方式,比如ODBC等。

5、打开hiveos应用管理。找到无线网络管理。选择需要连接的无线网络,输入密码配对连接即可。以上就是hiveos连接无线的方法。

hive常用命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于hive使用教程、hive常用命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接