spark启动命令是什么,spark启动的模式有哪些,并简要说明

作者:admin 发布时间:2024-11-09 22:44 分类:资讯 浏览:1

本篇文章给大家谈谈spark启动命令是什么,以及spark启动的模式有哪些,并简要说明对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、如何在本地安装运行Spark?

- 2、spark必须要hadoop吗

- 3、如何运行Spark程序

- 4、idea上的项目怎么在虚拟机上的spark平台上运行

- 5、Spark-shell和Spark-submit提交程序的区别

如何在本地安装运行Spark?

1、安装JDK 相对于Linux、Windows的JDK安装更加自动化,用户可以下载安装Oracle JDK或者OpenJDK。只安装JRE是不够的,用户应该下载整个JDK。安装过程十分简单,运行二进制可执行文件即可,程序会自动配置环境变量。

2、在Spark中采用本地模式启动pyspark的命令主要包含以下参数:master:这个参数表示当前的pyspark要连接到哪个master,如果是local[*],就是使用本地模式启动pyspark,其中,中括号内的星号表示需要使用几个CPU核心(core)。

3、独立部署模式:独立部署模式是最常见的Spark部署方式,它可以在没有其他计算框架的情况下独立运行。这种部署方式需要在每个节点上安装Spark,并配置集群环境。

4、本地模式运行spark-shell非常简单,只要运行以下命令即可,假设当前目录是$SPARK_HOME MASTER=local $ bin/spark-shell MASTER=local就是表明当前运行在单机模式。

spark必须要hadoop吗

不一定,如果你不用Hadoop的HDFS和YARN,完全可以在学习Spark的时候从本地载入数据,部署用standlone模式。Spark替代的是Hadoop中的MapReduce编程范式,不包括存储和资源管理模块。

必须在hadoop集群上,它的数据来源是HDFS,本质上是yarn上的一个计算框架,像MR一样。Hadoop是基础,其中的HDFS提供文件存储,Yarn进行资源管理。可以运行MapReduce、Spark、Tez等计算框架。

一般都是要先装hadoop的,如果你只是玩Spark On Standalon的话,就不需要,如果你想玩Spark On Yarn或者是需要去hdfs取数据的话,就应该先装hadoop。

理论上来讲,学习spark和storm是不需要学习hadoop的。spark和storm都是独立的开源项目,在完整性上是self-constrained的,完全可以独立学习。

如果只是以伪分布式模式安装Spark,可以不安装Hadoop,因为可以直接从本地读取文件。如果以完全分布式模式安装Spark,由于我们需要使用HDFS来持久化数据,一般需要先安装Hadoop。

如何运行Spark程序

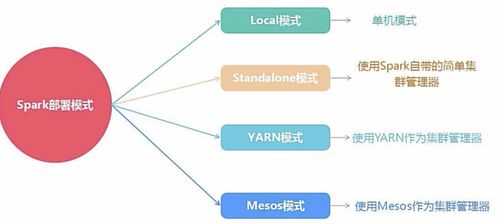

1、有以下四个步骤。构建SparkApplication的运行环境(启动SparkContext),SparkContext向资源管理器(可以是Standalone、Mesos或YARN)注册并申请运行Executor资源。

2、简述:YARN(Yet Another Resource Negotiator)是Hadoop的资源管理系统。在YARN模式下,Spark可以作为YARN的一个应用程序运行,并使用YARN进行资源管理。拓展:这种模式允许Spark与Hadoop等其他YARN应用程序共享集群资源。

3、Spark脚本提交/运行/部署1spark-shell(交互窗口模式)运行Spark-shell需要指向申请资源的standalonespark集群信息,其参数为MASTER,还可以指定executor及driver的内存大小。

4、/run脚本运行你的程序了例如:./run spark.examples.SparkPi spark://masterIP:port注意,如果程序涉及IO操作起默认路径为SPARK_HOME;至于如何修改这个路径,有待研究 转载,仅供参考。

idea上的项目怎么在虚拟机上的spark平台上运行

1、第二种方法是首先在linux操作系统上生成intellij项目文件,然后在intellij IDEA中直接通过“Open Project”打开项目即可。

2、可以运行。创建项目:在Eclipse中创建一个新的项目,作为导入IntelliJIDEA项目的容器。导入项目:将IntelliJIDEA项目目录导入到Eclipse中。

3、复用上例中的目录结构,也可以新建一个 sbt 项目。新建文件 StreamDataSparkDemo.scala 以上,我们从Kafaka服务器读取一个 topic 为 spark 的流,然后进行展示。运行程序,输出如下:取出数据之后,就可以用于实时分析了。

4、你好,配置一下环境变量SPARK_LOCAL_IP=10.1 就OK了。 目前处理方式就是debug代码逻辑问题就在windows中。预发布测试就在linux中测试。

5、IDEA的安装 官网jetbrains.com下载IntelliJ IDEA,有Community Editions 和& Ultimate Editions,前者免费,用户可以选择合适的版本使用。

Spark-shell和Spark-submit提交程序的区别

1、集成方式不同、执行效率不同。SparkSQL是Spark的一个模块,用于处理结构化数据,完美整合了SQL查询和Spark编程。而传统SQL是直接编写SQL语句来执行查询。

2、sc 代表着 Spark 的上下文,通过该变量可以执行 Spark 的一些操作,而 sqlCtx 代表着 HiveContext 的上下文。spark-submit 在Spark0之后提供了一个统一的脚本spark-submit来提交任务。

3、我们通常都使用spark-submit 来提交任务,对于不同的部署模式,需要使用不同的参数来指定executor数,实际生产环境中最常使用的部署模式就是 ON YARN 和 Standalone两种模式。

4、Spark脚本提交/运行/部署1spark-shell(交互窗口模式)运行Spark-shell需要指向申请资源的standalonespark集群信息,其参数为MASTER,还可以指定executor及driver的内存大小。

关于spark启动命令是什么和spark启动的模式有哪些,并简要说明的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接