重启kafka命令,kafka重置offset

作者:admin 发布时间:2024-06-30 02:00 分类:资讯 浏览:26

今天给各位分享重启kafka命令的知识,其中也会对kafka重置offset进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

- 1、「SpringCloud」(三十八)搭建ELK日志采集与分析系统

- 2、canal+Kafka实现mysql与redis数据同步

- 3、记录一次kafka的报错

- 4、kafka集群一台broker挂掉,解决办法

- 5、kafka-docker上使用+常用指令

- 6、kafka为什么会自动关闭

「SpringCloud」(三十八)搭建ELK日志采集与分析系统

在微服务架构中,日志分析系统是性能监控和问题定位的基石。Elasticsearch(存储)、Logstash(处理)和Kibana(展示)组成的ELK堆栈,配合Kafka处理高并发场景下的日志增长,Filebeat作为高效日志采集器,使得整个系统无缝协作。

ELK是 Elasticsearch 、Filebeat、Logstash、Kibana的简称。jdk版本推荐8以上,ELK各版本推荐一致,下载可搜索官网。

日志的采集灵活性是我们选择日志采集方案更看重的因素,所以logstash属于首先方案, 它可以兼顾多种不同系统和应用类型等因素的差异,从源头上进行一些初步的日志预处理。

解决这种问题的方法,需要构建一个日志管理平台:对日志进行汇聚和分析,并通过Web UI授权相关人员查看日志权限。 日志系统选择与对比 关于企业级日志管理方案,比较主流的是ELK stack和Graylog。

canal+Kafka实现mysql与redis数据同步

1、读Redis:热数据基本都在Redis 2)写MySQL:增删改都是操作MySQL 3)更新Redis数据:MySQ的数据操作binlog,来更新到Redis Redis更新。

2、结构不同 先讲MySQL,MySQL中一个事务提交之后就永久写入了,同时将事务的操作写入日志。然后,slave从master中请求日志,复制这个事务的操作(注意不是sql语句)。

3、这里还可以基于binlog使用mysql_udf_redis,将数据库中的数据同步到Redis。

4、【方案一】http://?sort=created 程序实现mysql更新、添加、删除就删除redis数据。

5、数据变更捕获与集成: Kafka的Change Data Capture (CDC) 功能,使得数据源之间的变更传输变得简单高效,为数据同步和迁移提供了强大支持,如从源系统流向ElasticSearch或Redis等目标系统。

6、服务部署:在每个机房都部署一套网关(NG)、注册中心、微服务,尽量避免跨机房调用(就近调用降低延时)。同时,Mysql、Redis等数据存储服务使用同一套“活”集群,同时有另一套备份的Mysql、Redis会做数据同步。

记录一次kafka的报错

1、最近部门使用的Kafka从v0.2升级到v1,遇到了几个错误,记录一下。在灰度producer的时候,遇到了这个问题。

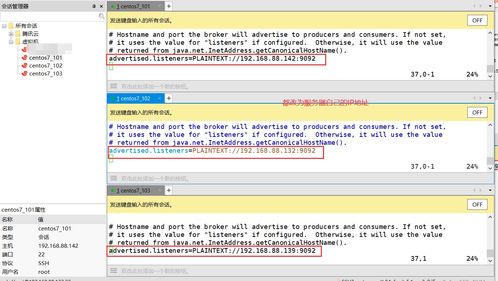

2、listeners:启动kafka服务监听的ip和端口,可以监听内网ip和0.0.0.0(不能为外网ip),默认为java.net.InetAddress.getCanonicalHostName()获取的ip。

3、在Windows中安装Kafka成功,第一次启动也没有问题。

4、本文将围绕Kafka,先介绍其整体架构和关键概念,再深入分析其架构之中存在的安全问题,最后分享下Transwarp在Kafka安全性上所做的工作及其使用方法。

kafka集群一台broker挂掉,解决办法

我的问题到这里就解决了: 启动kafka集群三个节点,然后停掉其中任意一个节点,集群是可以正常工作的。

重新消费。如果是在消费端丢失数据,那么多次消费结果完全一模一样的几率很低。如果是在写入端丢失数据,那么每次结果应该完全一样(在写入端没有问题的前提下)。

也就是说,理论上,要完全让kafka保证单个broker不丢失消息是做不到的,只能通过调整刷盘机制的参数缓解该情况。比如,减少刷盘间隔,减少刷盘数据量大小。时间越短,性能越差,可靠性越好(尽可能可靠)。这是一个选择题。

环境:现象:golang微服务内存占用超过1G,查看日志发现大量kafka相关错误日志,继而查看kafka集群,其中一个kafka节点容器挂掉了。

有controller通知集群中所有broker更新其MetadataCache信息;或者增加某个topic分区的时候也会由controller管理分区的重新分配工作 实际上,Broker 在启动时,会尝试去 ZooKeeper 中创建 /controller 节点。

kafka-docker上使用+常用指令

按照菜鸟的步骤,使用yum安装即可。常用指令如下图,直白用法点我,官方介绍点击我备注:RUN命令在image文件的构建阶段执行,执行结果都会打包进入image文件;CMD命令则是在容器启动后执行。

docker exec -it zookeeper /bin/sh 这时查看zk节点只有一个zookeeper docker退出当前容器 快捷键:第一次尝试启动容器是用的第一种方式,后面发现在容器外面连接不了kafka,可能是因为生成的kafka地址是容器内地址。

使用docker命令可快速在同一台机器搭建多个kafka,只需要改变brokerId和端口 中间两个参数的 19160.102 改为 宿主机器 的IP地址,如果不这么设置,可能会导致在别的机器上访问不到 kafka。

kafka为什么会自动关闭

1、内网IP只能在内网局域网访问连接,在外网是不能认识内网IP不能访问的。如有路由权限,且路由有固定公网IP,可以通过路由的端口映射,实现外网访问内网。

2、因为 Leader 副本天然就在 ISR 中,如果 ISR 为空了,就说明 Leader 副本也“挂掉”了,Kafka 需要重新选举一个新的 Leader。可是 ISR 是空,此时该怎么选举新 Leader 呢? Kafka 把所有不在 ISR 中的存活副本都称为非同步副本 。

3、发信号之后,一直tail着kafka日志,看到正常关闭。

4、消息生产者可以选择将消息发送到指定分区或让Kafka根据一定的负载均衡策略自动选择分区。

5、自动提交的优点是方便,但是可能会重复处理消息 不足:broker在对提交请求作出回应之前,应用程序会一直阻塞,会限制应用程序的吞吐量。因此,在消费者关闭之前一般会组合使用commitAsync和commitSync提交偏移量。

6、因为我们业务会比较特殊,会在producer端cache数据到一定量级再send,以为是msg过大导致的,调试了许多参数都不见效。后面查阅github上相关问题看到一个说发送到错误的topic的时候会报错。

重启kafka命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于kafka重置offset、重启kafka命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接