hadoop命令权限,hadoop修改权限777

作者:admin 发布时间:2024-06-11 11:54 分类:资讯 浏览:19

今天给各位分享hadoop命令权限的知识,其中也会对hadoop修改权限777进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

- 1、linux权限问题,配置hadoop的时候提示权限不够。谢谢!

- 2、在Linux虚拟机上配置Hadoop,在初始化时显示权限不够

- 3、java.api操作hadoop的hdfs需要什么权限吗?

- 4、hadoop查询哪些租户对其有哪些权限

- 5、各位大神!在centos虚拟机linux下怎样给普通用户权限进行hadoop...

linux权限问题,配置hadoop的时候提示权限不够。谢谢!

要注意使用对应用户创建解压文件。并随时使用ll –a 查看文件权限。

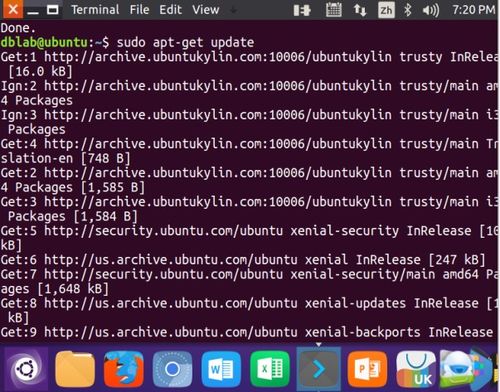

使用sudo命令:在命令前加上sudo,输入管理员密码,可以临时提升权限执行命令。 修改文件/目录权限:使用chmod命令修改文件/目录权限,将其修改为当前用户拥有读写执行权限。

可能是在不小心的情况下打开了这个开关,只需要找到开关关闭写保护即可。通常情况下我们的u盘格式都是FAT32的,我们首先把它转换成NTFS格式。更改磁盘策略,这个方法重启后也不会出现U盘被写保护。

在Linux虚拟机上配置Hadoop,在初始化时显示权限不够

要注意使用对应用户创建解压文件。并随时使用ll –a 查看文件权限。

linux格式化u盘权限不够的原因在于:可能是在不小心的情况下打开了这个开关,只需要找到开关关闭写保护即可。通常情况下我们的u盘格式都是FAT32的,我们首先把它转换成NTFS格式。

这个就是你的系统设置借权限 linux权限不够一般会怎么做?方法一:可以通过su命令切换到root用户来运行命令。需要输入root用户的密码。用法示例:切换到root用户$su方法二:使用sudo命令,针对单个命令授予临时权限。

不是权限的问题的话看看是不是重复格式化造成的,把你的dfs.dir指向的文件夹全部清理一下。name和打他全部清理掉。最好把coresite。

linux运行脚本显示权限不够怎么办?可能你没有为xsetup文件加上可执行权限,想知道有没有可执行权限方法如下:先su到root。

java.api操作hadoop的hdfs需要什么权限吗?

不知道你说的“调用Filesystem命令”是什么意思;使用hadoop fs -rm可以正常执行,MapReduce也可以正常读写HDFS文件,说明HDFS文件系统没有问题。你不妨试一试hadoop fs -chmod a+rwx path设置rwx权限后,再试一次。

安装 Java 运行环境(JRE)或 Java 开发工具包(JDK)。Hadoop 是使用 Java 语言开发的,因此需要安装 Java 运行环境才能运行。配置 Java 环境变量。

原始权限为750的话,你若在自己电脑运行上述程序,它会自动获取当前计算机的登录用户,假设为wyc,去访问hdfs,很显然,你的程序连process目录都进不去的。

atorg.apache.hadoop.hdfs.server.namenode.NameNode.main(NameNode.java:1288)根据列外是不能创建一个目录,有了上面的经验我就知道了是没有建目录的权限。

HDFS支持用户数量限制和访问权限控制,不支持软硬链接,用户可以自己实现软硬链接。NameNode控制该命名空间,命名空间任何变动几乎都要记录到NameNode中。应用可以在HDFS中对文件声明复制次数,这个次数叫做复制系数,会被记录到NameNode中。

hadoop 的主要配置都在 hadoop-1/conf 下 1》修改hadoop-env.sh vim hadoop-env.sh 修改该文件的 : export JAVA_HOME=/opt/SoftBasic/jdk0_45 你的JDK的安装目录。

hadoop查询哪些租户对其有哪些权限

1、HDFS权限、YARN资源使用权限、Container使用主机资源权限、主机(hadoop节点)之间的权限。HDFS权限、YARN资源使用权限、Container使用主机资源权限、主机(hadoop节点)之间的权限。

2、kerberos主要负责平台用户的用户认证,sentry则负责数据的权限管理。Apache Sentry是Cloudera公司发布的一个Hadoop开源组件,它提供了细粒度级、基于角色的授权以及多租户的管理模式。

3、修改/etc/sudoers文件,进入超级用户,因为没有写权限,所以要先把写权限加上chmod u+w /etc/sudoers。

4、有了上面的经验我就知道了是没有建目录的权限。所以我直接就在/var/下建了一个目录叫做hadoop/,并授予了权限。再格式化namenode,成功启动。但是转到子节点上输入jps查看,发现并没有完全启动。知道node也有同样问题。

5、前边主要介绍单机版的配置,集群版是在单机版的基础上,主要是配置文件有所不同,后边会有详细说明) 准备工作 1 创建用户 创建用户,并为其添加root权限,经过亲自验证下面这种方法比较好。

6、大数据平台上细粒度的访问权限控制各家都在做,当然平台厂商方面主导的还是Cloudera和Hortonworks两家,Cloudera主推Sentry为核心的授权体系;Hortonwork一方面靠对开源社区走向得把控,另一方面靠收购的XA Secure。

各位大神!在centos虚拟机linux下怎样给普通用户权限进行hadoop...

1、创建用户useraddaa。root用户给aa设置密码passwdaa后输入两遍密码。设置权限:chown-Rredis:redis/aa。切换用户su-aa。

2、在linux中添加ftp用户,并设置相应的权限,操作步骤如下:环境:ftp为vsftp。被限制用户名为test。

3、Linux提供了集成的系统管理工具userconf,它可以用来对用户账号进行统一管理。

关于hadoop命令权限和hadoop修改权限777的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接