sqoop命令,sqoop命令在哪里执行

作者:admin 发布时间:2024-05-10 20:47 分类:资讯 浏览:9

本篇文章给大家谈谈sqoop命令,以及sqoop命令在哪里执行对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、hbase导入导出方式有哪些

- 2、如何安装配置伪分布式环境下的sqoop

- 3、如何将mysql数据导入Hadoop之Sqoop安装

- 4、hbase数据库是关系型数据库吗

- 5、sqoop命令,oracle导入到hdfs、hbase、hive

- 6、Sqoop工作原理是什么?

hbase导入导出方式有哪些

1、Put API Put API可能是将数据快速导入HBase表的最直接的方法。但是在导入【大量数据】时不建议使用!但是可以作为简单数据迁移的选择,直接写个代码批量处理,开发简单、方便、可控强。

2、尽管importtsv 工具在需要将文本数据导入HBase的时候十分有用,但是有一些情况,比如导入其他格式的数据,你会希望使用编程来生成数据,而MapReduce是处理海量数据最有效的方式。这可能也是HBase中加载海量数据唯一最可行的方法了。

3、所以我们只能自己来写一个MR了,编写一个Hbase的MR,官方文档上也有相应的例子。我们用来加以化妆就得到我们想要的了。

如何安装配置伪分布式环境下的sqoop

1、安装单节点的Hadoop无须配置,在这种方式下,Hadoop被认为是一个单独的Java进程,这种方式经常用来调试。

2、分布式和伪分布式这两种配置也很相似,唯一不同的地方是伪分布式是在一台机器上配置,也就是名字节点(namenode)和数据节点(datanode)均是同一台机器。

3、常见的在伪分布式环境下使用的Shell命令包括:start-dfs.sh启动分布式文件系统、start-yarn.sh启动资源管理器、hadoop fs操作分布式文件系统、hadoop jar运行Hadoop任务等。

如何将mysql数据导入Hadoop之Sqoop安装

hadoop的每个节点下lib文件夹中要有mysql的jar包和sqoop的jar包。在HDFS的某个目录上的数据格式和MYSQL相应的表中的字段数量一致。

在行键选择那里,通过用“”,将需要做行键的多个列写在一起就可以了。例如要将a和b列同时做行键,那么--hbase-row-key a,b就可以了。

命令行:net start mysql 如果能启动,那说明安装成功了。

它连接MySQL主服务读二进制日志,然后提取发生在主服务上的行插入事件,解码事件,提取插入到行的每个字段的数据,并使用满意的处理程序得到被要求的格式数据。把它追加到HDFS 中一个文本文件。

sqoop导入mysql中表不需要手动创建。连接到hive的默认数据库后会自动创建的。

hdfs显示但是hive里面没有的话,很可能hive配置使用的是自带的deby数据库。hive的配置文件弄好,如果用sqoop的话,把hive的配置文件hive-site.sh拷贝一份到sqoop的conf目录下,让sqoop知道保存的数据是到mysql元数据库的hive。

hbase数据库是关系型数据库吗

非关系型数据库,列存储和文档存储(查询低延迟),hbase是nosql的一个种类,其特点是列式存储。

HBase是一种分布式、面向列的NoSQL数据库,而传统数据库通常是基于关系模型的关系型数据库。这两种数据库在数据存储方式上有所区别。HBase采用了列式存储的方式,将数据按列存储,适合存储大规模、稀疏的数据。

关于hbase的描述正确的是是Google的BigTable的开源实现;运行于HDFS文件系统之上;HBase是一个开源的非关系型分布式数据库;主要用来存储非结构化和半结构化的松散数据。

sqoop命令,oracle导入到hdfs、hbase、hive

在行键选择那里,通过用“”,将需要做行键的多个列写在一起就可以了。例如要将a和b列同时做行键,那么--hbase-row-key a,b就可以了。

使用HiveQL加载数据相对简单,适用于较小规模的数据集。例如,使用`LOAD DATA INPATH`命令可以将数据从HDFS中导入到Hive表中。

Sqoop是一款用于把关系型数据库中的数据导入到hdfs中或者hive中的工具,当然也支持把数据从hdfs或者hive导入到关系型数据库中。Sqoop也是基于Mapreduce来做的数据导入。

连接到hive的默认数据库后会自动创建的。

楼主说的是Hive,不是HBase.从Oracle里面头导出数据为平面文件后,导入HDFS里面,Hive里面的表结构是要自己手工定的。你可以安装下SQOOP,注意这个跟HADOOP的版本要对应的,不然会出现一些问题。

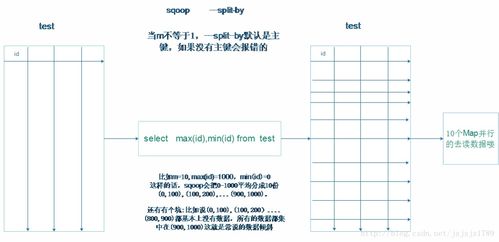

Sqoop工作原理是什么?

1、Sqoop 的工作原理简洁明了。它通过用户指定的SQL查询或指定的字段参数,从数据库中提取数据并导入到HDFS或Hive中。此外,Sqoop还能够利用数据库的导出工具进行数据抽取,但这通常受到数据库版本的支持限制。

2、数据清洗:MapReduce作为Hadoop的查询引擎,用于大规模数据集的并行计算。数据查询分析:Hive的核心工作就是把SQL语句翻译成MR程序,可以将结构化的数据映射为一张数据库表,并提供HQL(HiveSQL)查询功能。

3、Sqoop:这个是用于把Mysql里的数据导入到Hadoop里的。

sqoop命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于sqoop命令在哪里执行、sqoop命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

- 资讯排行

- 标签列表

- 友情链接